En la version 11gR2 del RAC la arquitectura del Cluster ready services ha cambiado considerablemente.

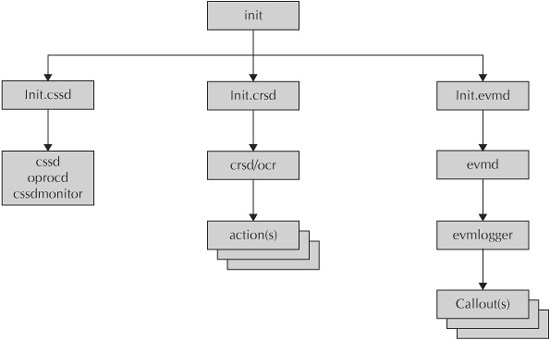

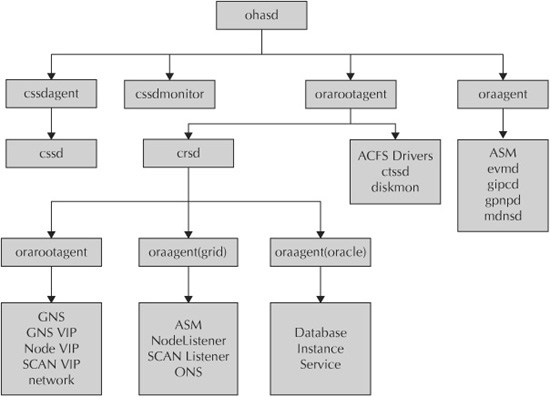

En estas dos imágenes, podemos ver el arbol de procesos en la version 10g-11gr1 y la 11gR2

Como podemos ver el arbol de procesos se ha dividido en dos ramas bien diferenciadas, el OAHSD que manejará los procesos de bajo nivel, y el CRSD que seguirá manejando estos procesos de alto nivel.

[table width=»650″ colwidth=»200|300|150″ colalign=»left|left|left»]

Elemento,Proceso ,Dueño

Oracle High Availability Service, ohasd ,init root

Cluster Ready Service (CRS), Cluster Ready Services, root

Cluster Synchronization Service (CSS), ocssd cssd monitor cssdagent ,grid owner

Event Manager (EVM), evmd evmlogger, grid owner

Cluster Time Synchronization Service (CTSS), octssd, root

Oracle Notification Service (ONS), ons eons, grid owner

Oracle Agent, oragent, grid owner

Oracle Root Agent, orarootagent, root

Grid Naming Service (GNS), gnsd, root

Grid Plug and Play (GPnP), gpnpd ,grid owner

Multicast domain name service (mDNS), mdnsd, grid owner

[/table]

Echemos un vistazo a estos daemons:

OAHASD

Es el primer proceso de todos, este es el que busca en el /etc/oracle/scls_scr/hostname

Además de usar este fichero (no es texto plano) también va a utilizar el directorio de /var/tmp/.oracle para conexiones named pipe

Wste demonio se arranca automáticamente desde el inittab y está respawneado, pero también puede hacerse desde

/etc/init.d/ini.oahsd run

El arranque y la parada será con

crscrl start crs crscrl stop crs

En caso de querer deshabilitar manualmente este arranque podemos hacerlo con

crsctl disable crs crsctl enable crs

Vamos a verlos por ramas:

OAHSD oraagent

Es el agente que administra /start/stop los procesos :

[table width=»650″ colwidth=»100|550″ colalign=»left|left»]

Proceso , Funcionalidad

ora.asm,• El ASM deberá de star levantado para que el CSRD pueda acceder a la información contenida dentro\, esto es levantado desde aquí para que esté disponible

ora.emvd,•Es el Event Monitor Daemon y se encarga de publicar y suscribir los eventos del nodo ( como puede ser «database down».

ora.mdnsd,•Multicast Domain Name Services\, es usado en el PNP\, así como para res`pmder al DNS peticiones del Grid Naming Service Daemon (GNSD)

ora.GPNPD,• Grid Plug and Play Daemon \, otro de los nuevos del 11R2 que se usa par ala sincronizacion del GPnP profile entre los nodos.

ora.GPNPD,• Encargado del nuevo protocolo de intercomuicacion del grid Grid IPC

[/table]

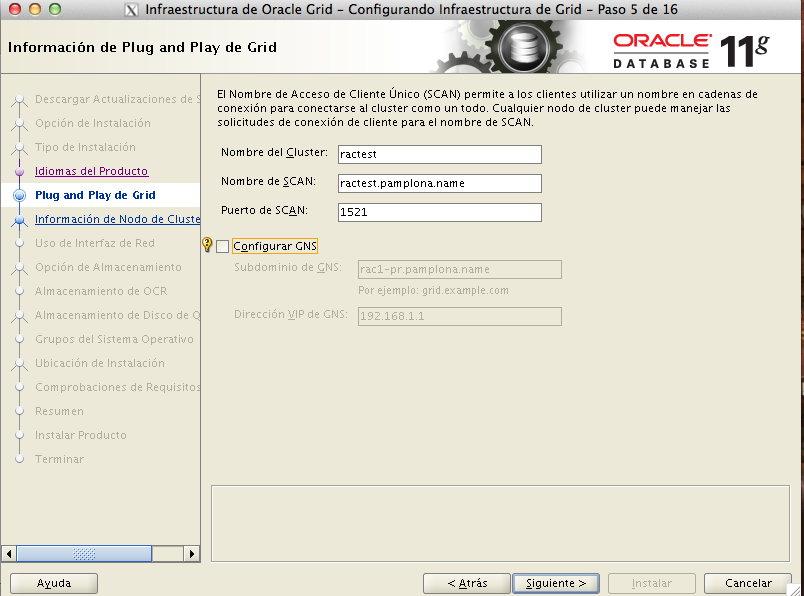

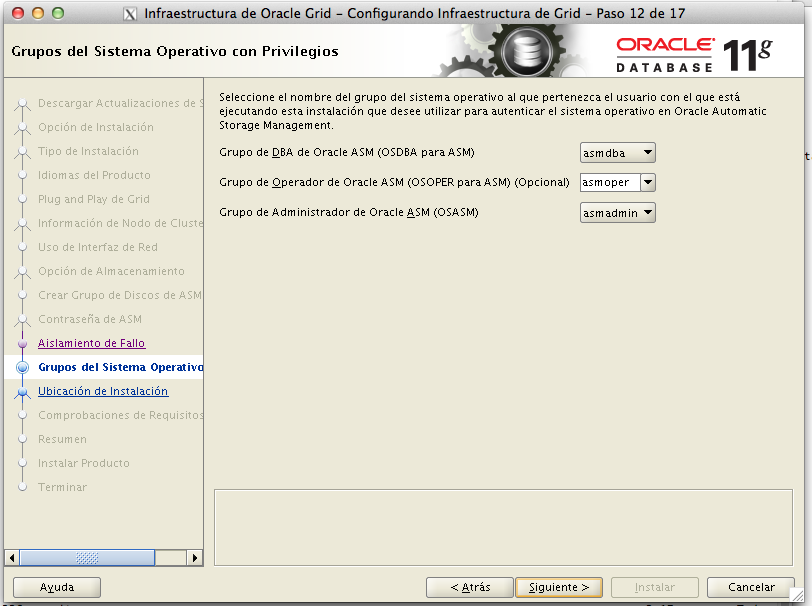

+12.04.29.png)

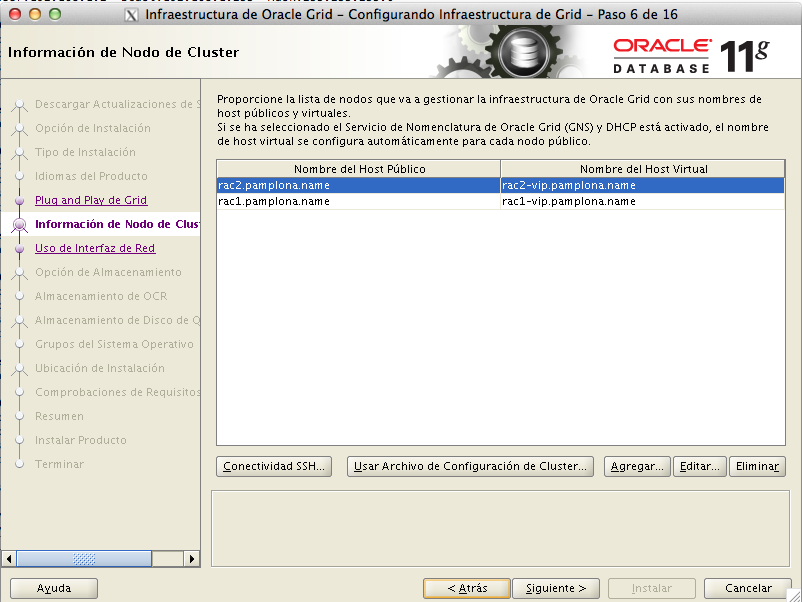

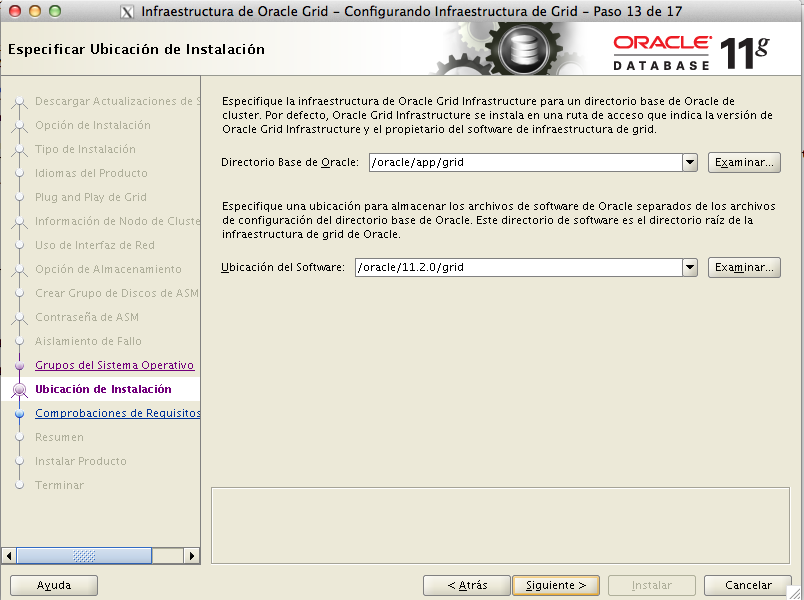

+12.06.29.png)

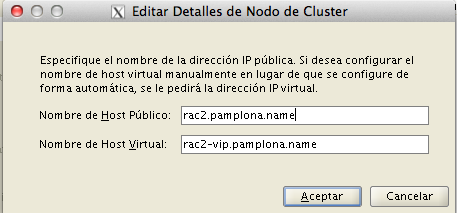

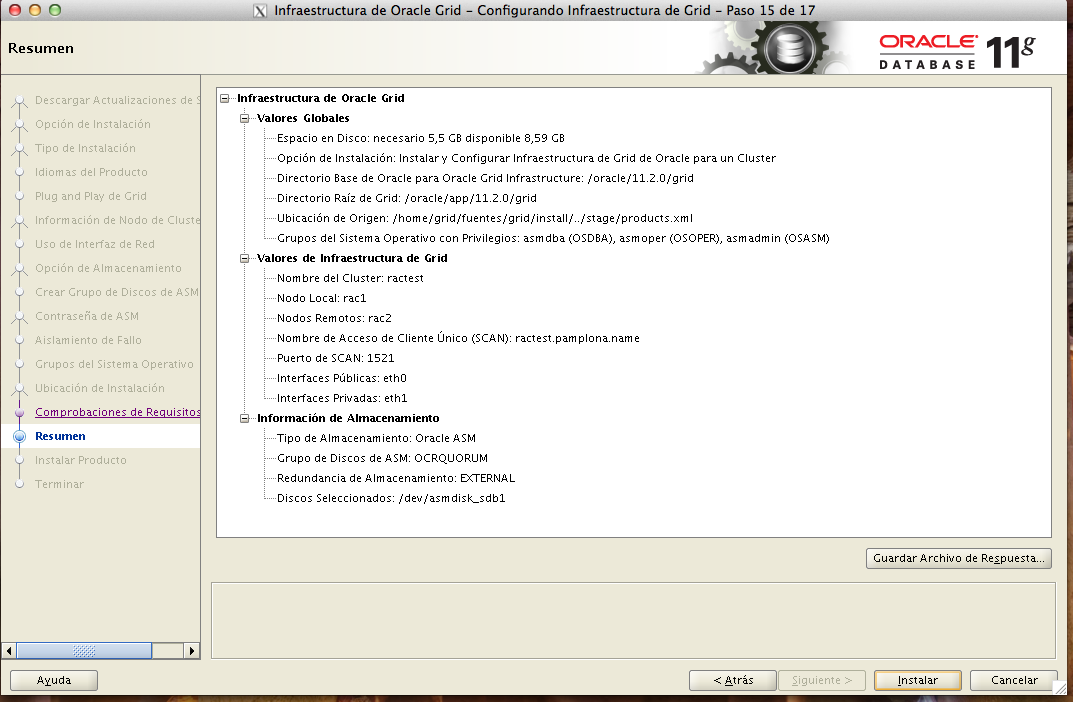

+12.12.37.png)