Ya esta disponible la version on-prem de oracle26ai, con lo que en esta entrada vamos a ver de manera sencilla los pasos para su instalacion.

Paqueteria

Vamos a partir de una OEL9 con la instalacion mínima, por lo que , tendremos que instalar algunos paquetes de comodities que nos facilitaran el trabajo, como son:

- binutils c

- compat-libstdc++-33

- elfutils-libelf

- elfutils-libelf-devel

- fontconfig-devel

- glibc

- glibc-devel

- ksh

- libaio

- libaio-devel

- libX11

- libXau

- libXi

- libXtst

- libXrender

- libXrender-devel

- libgcc

- libxcb

- make

- smartmontools

- sysstat

- net-tools

- nfs-utils

- python3

- python3-configshell

- python3-rtslib

- python3-six

- targetcli

- bc

- tmux

- parted

- tcpdump

- zip

- unzip

- xterm

- lsof

- lsscsi

Esto lo haremos con el comando

dnf install -y binutils compat-libstdc++-33 elfutils-libelf elfutils-libelf-devel \

fontconfig-devel glibc glibc-devel ksh libaio libaio-devel libX11 libXau libXi \

libXtst libXrender libXrender-devel libgcc libxcb make \

smartmontools sysstat net-tools nfs-utils python3 python3-configshell \

python3-rtslib python3-six targetcli bc compat-openssl11 tmux \

parted tcpdump zip unzip xterm lsof lsscsi \

Definicion de limites

Editaremos el fichero /etc/security/limits.d/30-oracle.conf añadiendo el contenido:

grid soft nofile 1024 grid hard nofile 65536 grid soft nproc 16384 grid hard nproc 16384 grid soft stack 10240 grid hard stack 32768 grid soft memlock 134217728 grid hard memlock 134217728 oracle soft nofile 1024 oracle hard nofile 65536 oracle soft nproc 16384 oracle hard nproc 16384 oracle soft stack 10240 oracle hard stack 32768 oracle soft memlock 134217728 oracle hard memlock 134217728

Configuration de red

Hay qequeños ajustes de red que deben de hacerse, si el sistema no esta propiamente registrado en un dns, deberemos de añadir la entrada en el fichero /etc/hosts por ejemplo

192.168.1.149 gigabyte.pamplona.name gigabyte

Ademas de esto, deberemos de poner en el fichero /etc/sysconfig/network el contenido

NOZEROCONF=yes

Y reniniciar el subsistema de red con el comando systemctl restart NetworkManager

Configuración de Huge Pages

Deberemos de meterle mano al GRUB para añadir la line transparent_hugepage=madvise

Editaremos el fichero /etc/default/grub

y donde ponía

GRUB_CMDLINE_LINUX=»resume=UUID=7691cd59-d957-4d6f-8d2b-e6825eea5403″

Lo modificaremos por

GRUB_CMDLINE_LINUX=»resume=UUID=7691cd59-d957-4d6f-8d2b-e6825eea5403 transparent_hugepage=madvise»

Y regeneraremos el grub con el comando grub2-mkconfig -o /boot/grub2/grub.cfg –update-bls-cmdline

Tras esto reiniciaremos el server.

Una vez reiniciado,comprobaremos que está así mirando el fichero /sys/kernel/mm/transparent_hugepage/enabled

[root@gigabyte ~]# cat /sys/kernel/mm/transparent_hugepage/enabled

always [madvise] neverPor que aparece ese valor y no always

Es el modo en el que Transparent HugePages se activan solo cuando un proceso lo solicita explícitamente, evitando los problemas de rendimiento que genera THP siempre activo (“always”) en bases de datos.Creacion de usuarios y grupos

En primer lugar, como siempre tendremos que crear la estructura de usuarios y grupos que soportara la instalacion

# Crear grupos

groupadd -g 54321 oinstall

groupadd -g 54322 dba

groupadd -g 54323 oper

groupadd -g 54324 backupdba

groupadd -g 54325 dgdba

groupadd -g 54326 kmdba

groupadd -g 54327 asmdba

groupadd -g 54328 asmoper

groupadd -g 54329 asmadmin

groupadd -g 54330 racdba# Usuario grid (Grid Infrastructure + ASM)

useradd -u 54331 -g oinstall -G dba,asmadmin,asmdba,asmoper,racdba grid

passwd grid# Usuario oracle (Base de datos)

useradd -u 54321 -g oinstall -G dba,oper,backupdba,dgdba,kmdba,asmdba,asmoper,asmadmin,racdba oracle

passwd oracle

Creacion de arbol de directirios

Una vez tenemos los usuarios, creareos el arbol de directorios donde queremos instalar el grid.

En nuestro caso sera

- /u01/app/grid Para el GRID

- /u01/app/oracle/product/26ai/dbhome_1 Para el motor de bases de datos

- /u01/app/oracle será nuestro ORACLE_BASE

# 3. Directorios OFA compartidos

mkdir -p /u01/app

mkdir -p /u01/app/oraInventory # Ubicacion del inventory de la base de datos

mkdir -p /u01/app/oracle # ORACLE_BASE compartido

mkdir -p /u01/app/oracle/product/26ai/dbhome_1 # Home de la primera base dedatos

mkdir -p /u01/app/grid # GRID_HOME

# 4. Permisos

chown -R oracle:oinstall /u01/app

chown -R grid:oinstall /u01/app/grid

chown -R oracle:oinstall /u01/app/oracle

chmod -R 775 /u01/app

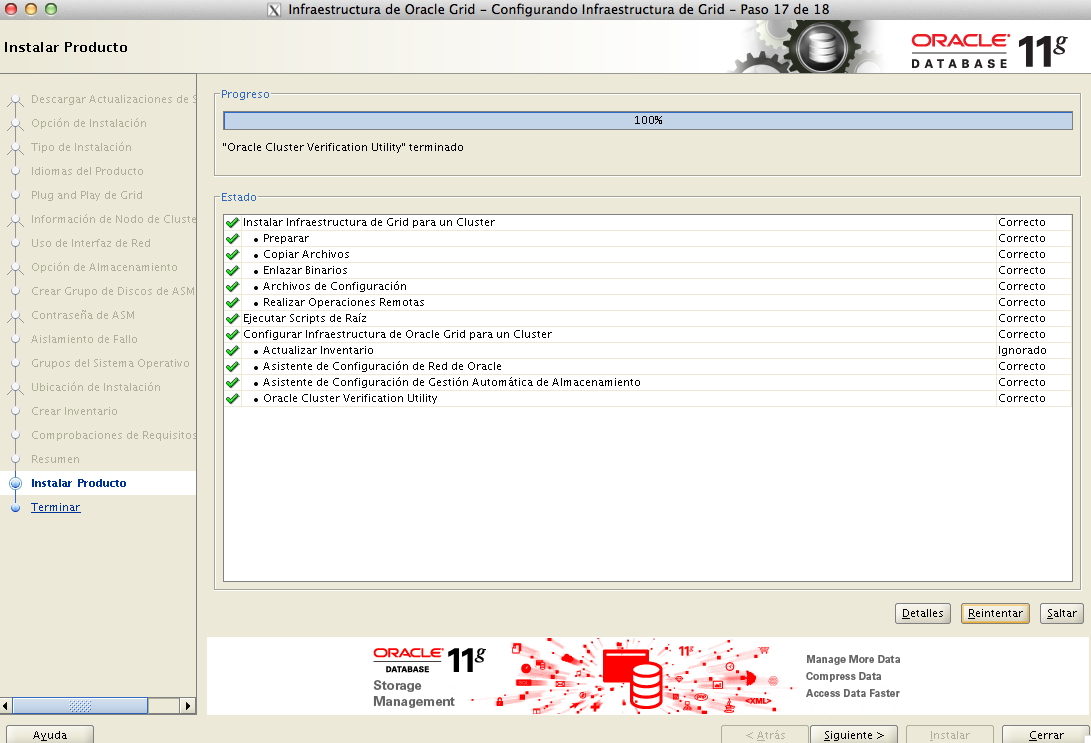

Con estos sencillos pasos,deberíamos de tener el servidor configurado para proceder a la instalacion , que podremos ver en las entradas

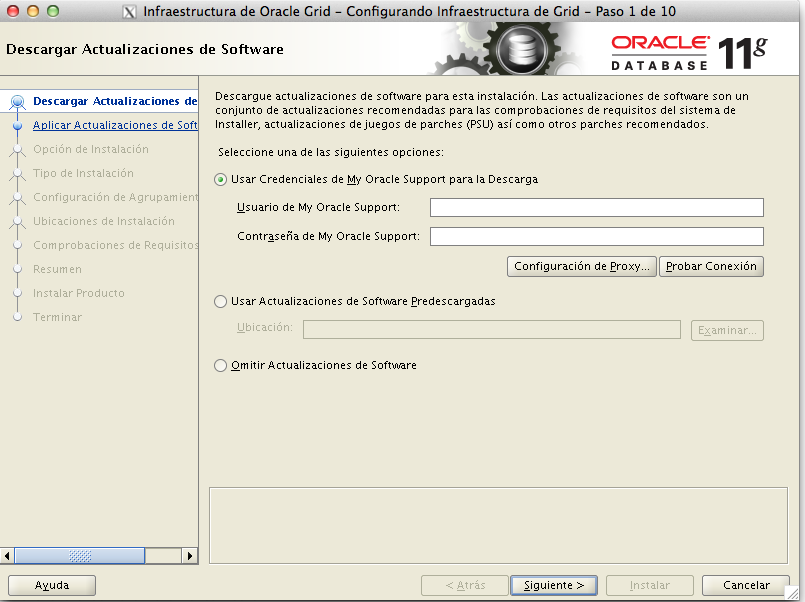

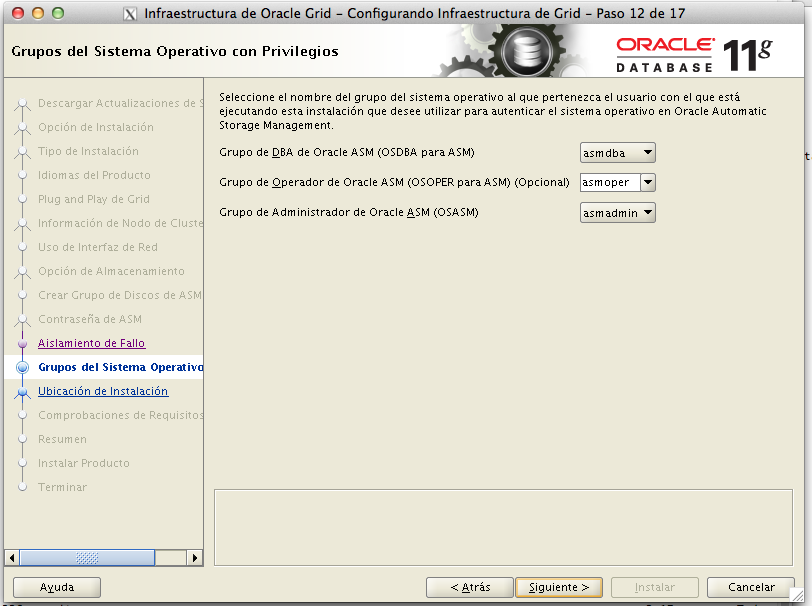

+12.04.29.png)

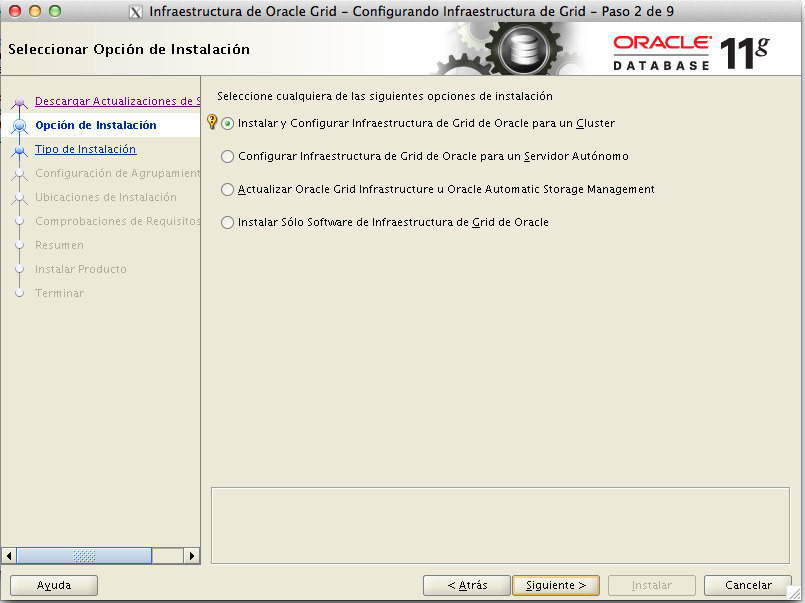

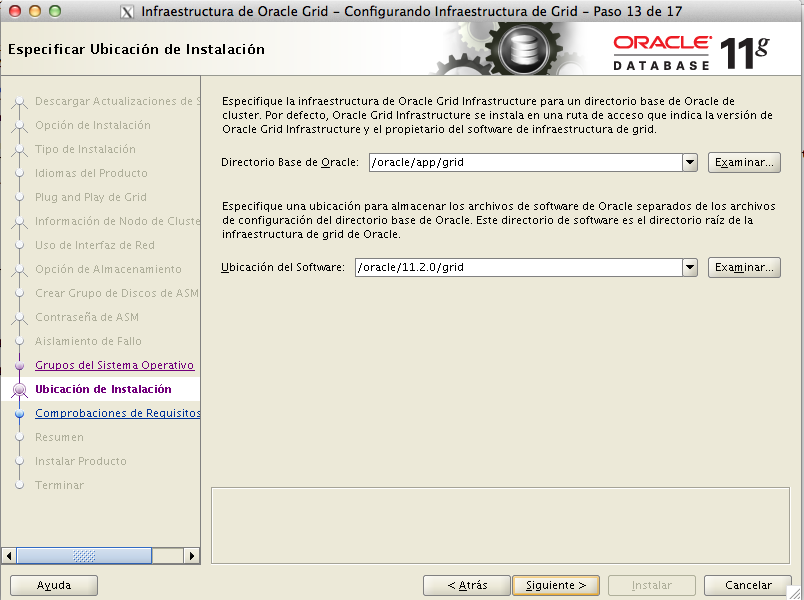

+12.06.29.png)

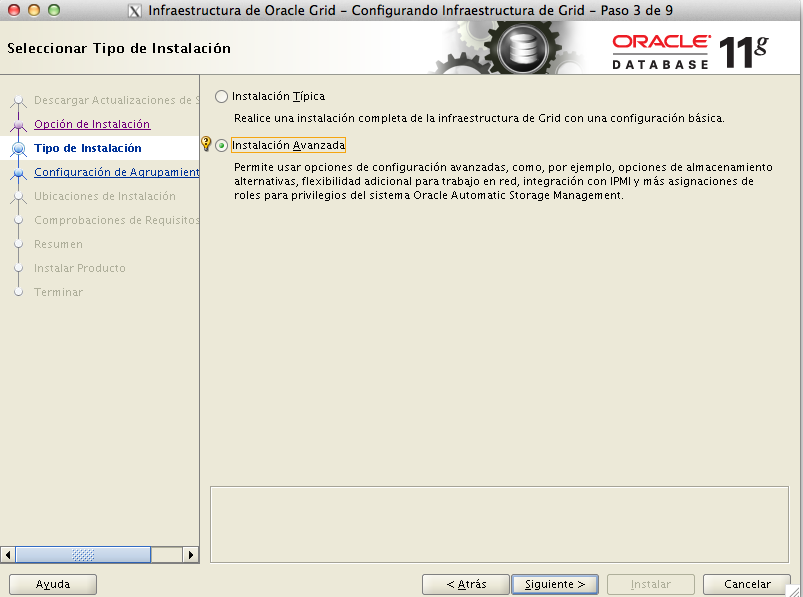

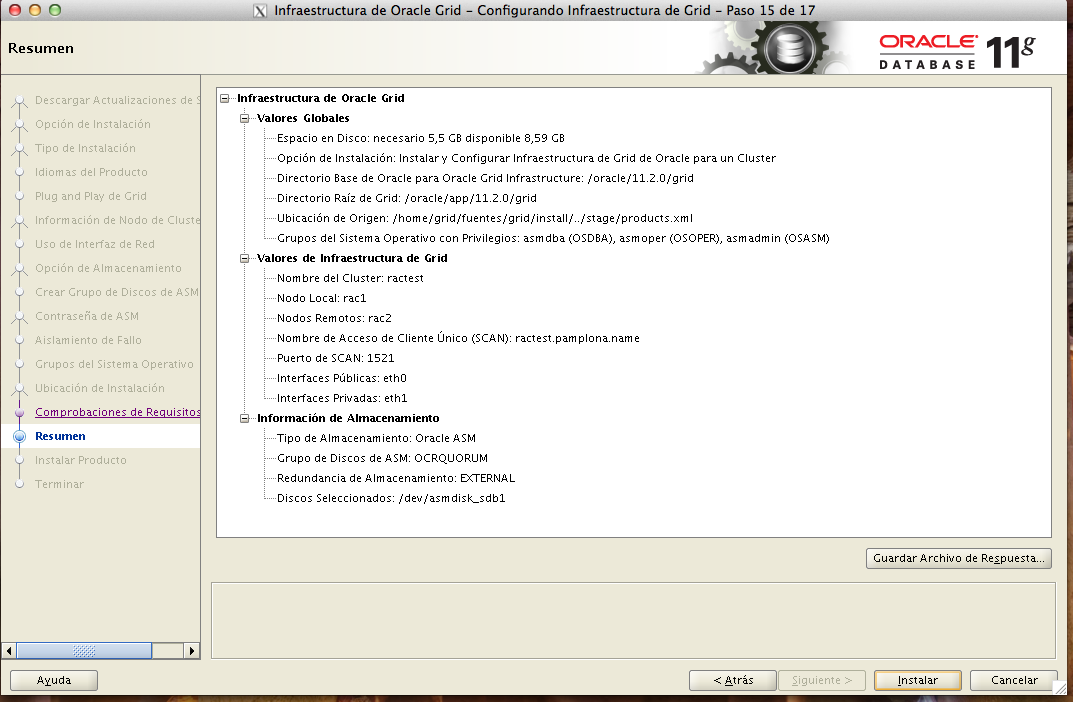

+12.12.37.png)