Vamos con una entrada rápida de esas que nos evitarán quebraderos de cabeza.

¿Sabemos cual es el usuario de administración de nuestro weblogic?

Cuando vamos a parchear nuestro Cloud control nos encontramos con lo siguiente

oracle@emc 18295180]$ opatchauto apply -analyze -property_file bundle.xml

OPatch Automation Tool

Copyright (c) 2013, Oracle Corporation. All rights reserved. OPatchauto version : 11.1.0.10.0 OUI version : 11.1.0.11.0 Running from : /u01/app/oracle/middleware/oms

Log file location : /u01/app/oracle/middleware/oms/cfgtoollogs/opatch/opatch2015-05-26_09-09-22AM_1.log

opatchauto log file: /u01/app/oracle/middleware/oms/cfgtoollogs/opatchauto/18295180/opatch_oms_2015-05-26_09-09-27AM_analyze.log

OPatch will do the following:

[Get weblogic Admin Server information] : Interview to get weblogic Admin Server of the GC Domain

[Generate configuration context of the GC Domain] : Get the configuration context for the GC Domain

[Run patch(es) deployment prerequisite checks] : Check the status of admin server of the GC Domain

: Check the status of OMS repository

[Run patch(es) binary prerequisite checks] :Check if all the patches can be applied to or rolled back from their corresponding Oracle Home

[Generate execution steps to apply and deploy the patch(es)] : Generate execution steps to modify bits and deploy artifacts of the patch

Please enter the WebLogic Admin Server URL for primary OMS(t3s://emc.pamplona.name :7103):>

Please enter the WebLogic Admin Server username for primary OMS:>

Please enter the WebLogic Admin Server password for primary OMS:>

¿Cual es ese usuario que nos piden?

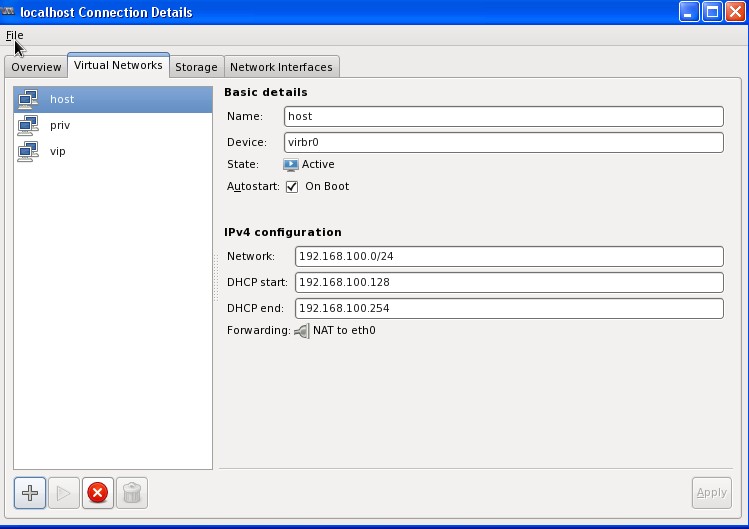

Si vamos a la URL que nos indica el fichero setupinfo.txt que nos dejó la instalacion en $ORACLE_HOME/install vemos que:

Admin Server URL: https://emc.pamplona.name:7103/console

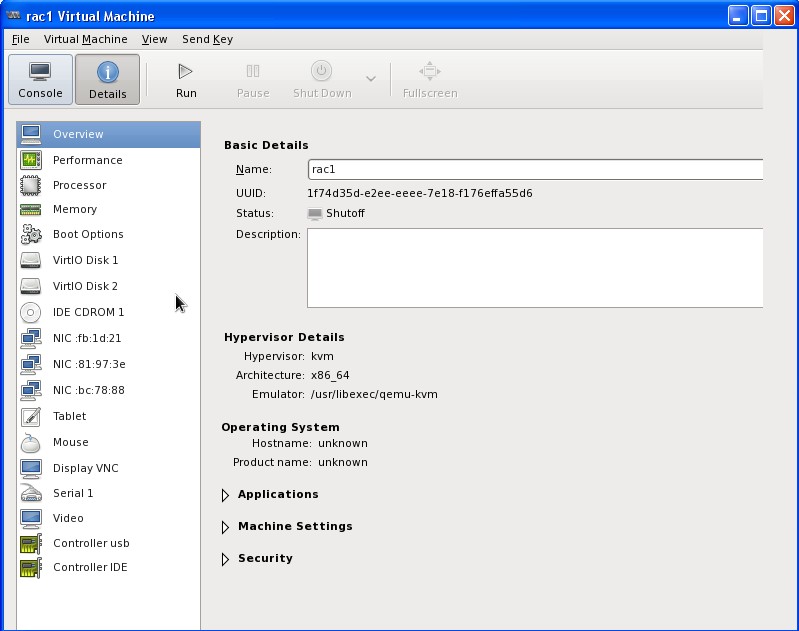

Y acediendo a esa URL nos encontramos con

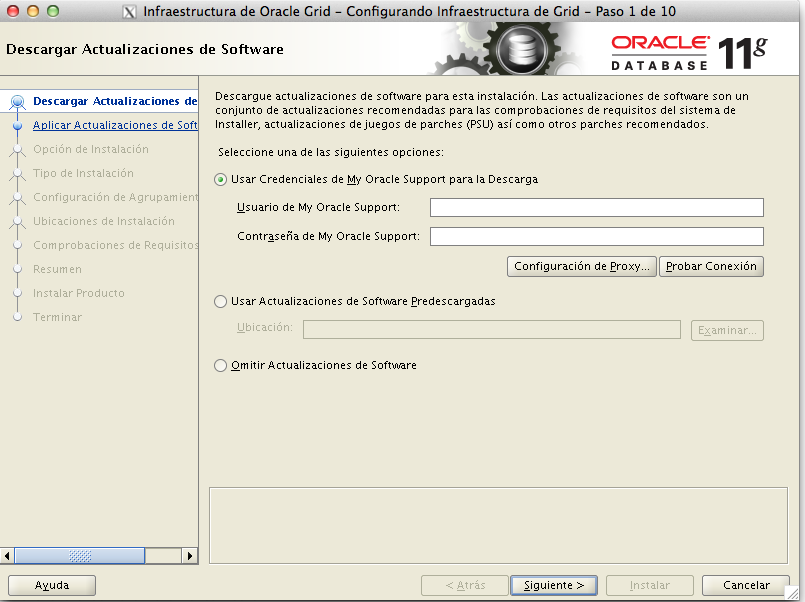

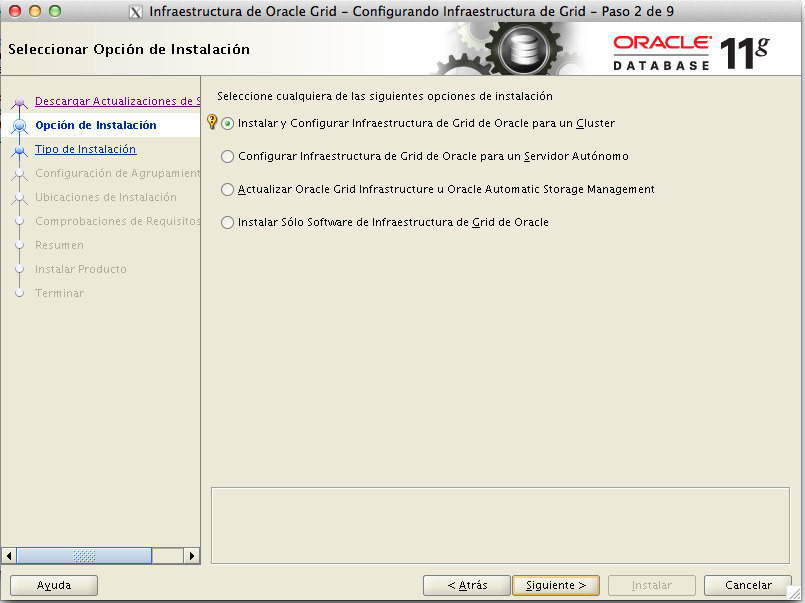

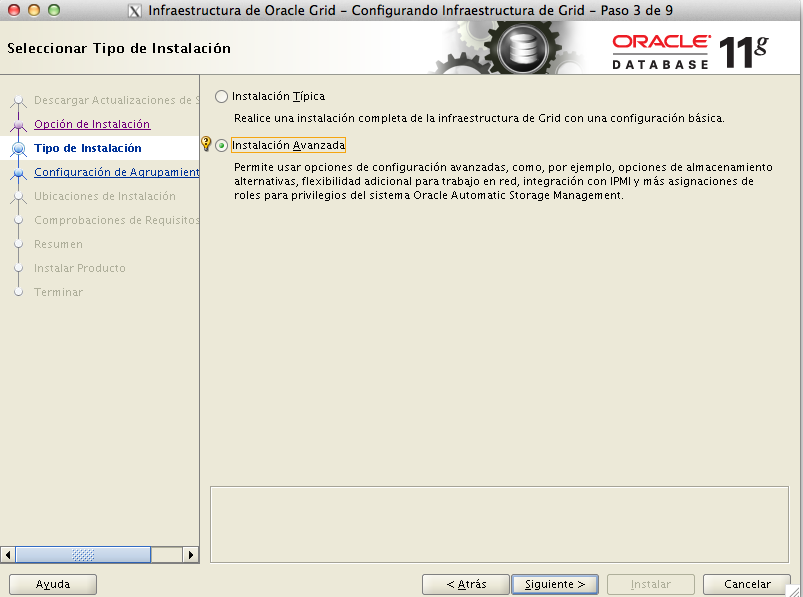

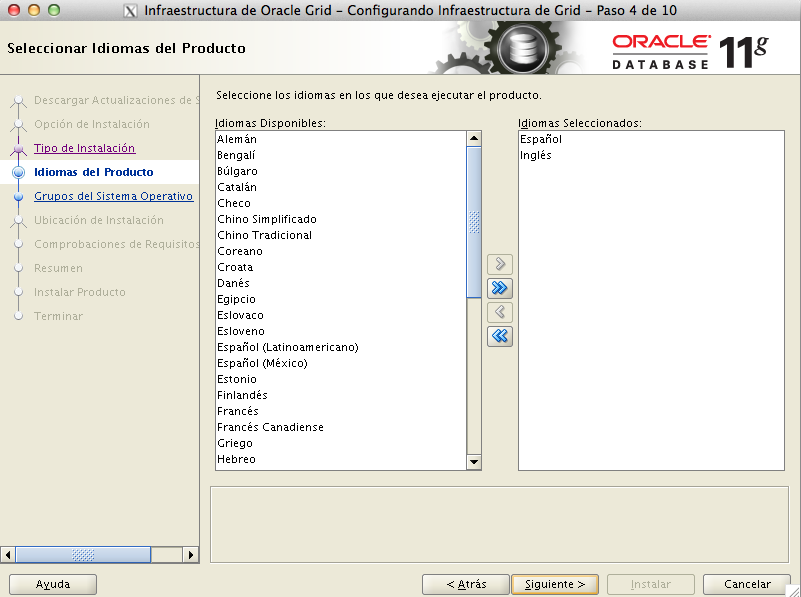

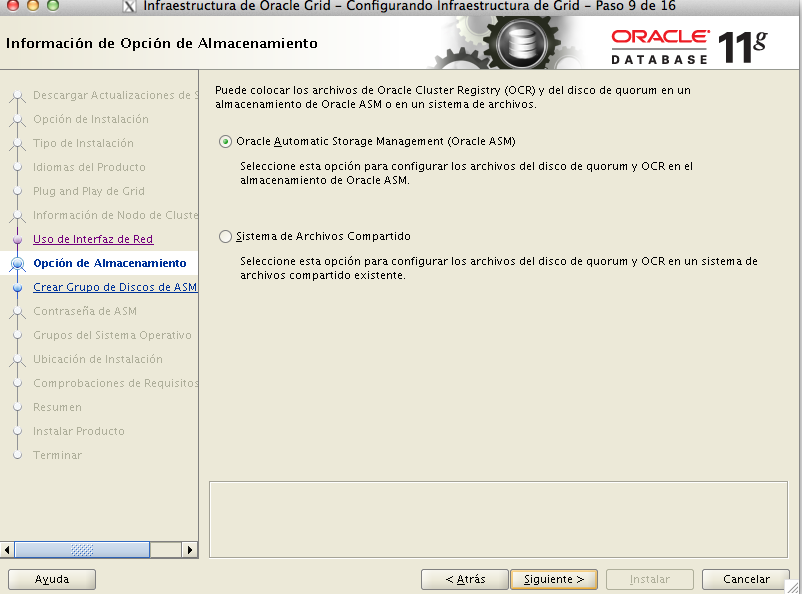

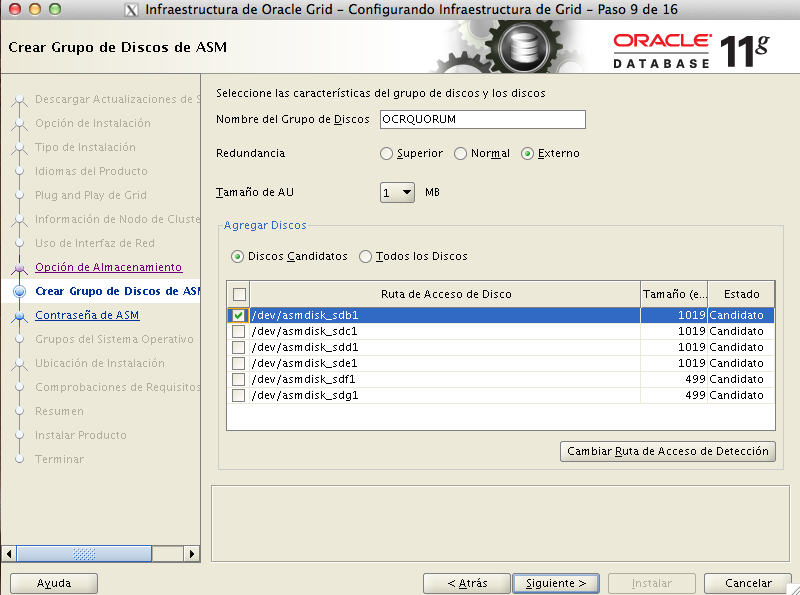

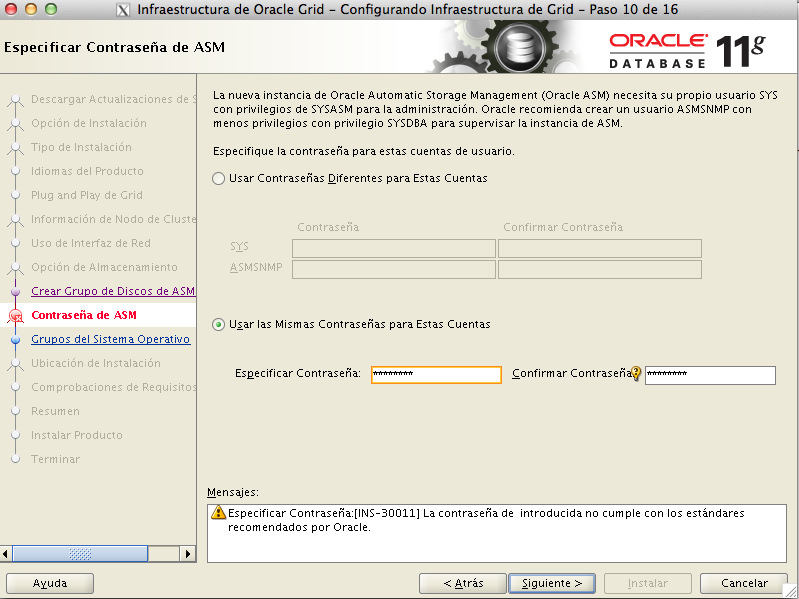

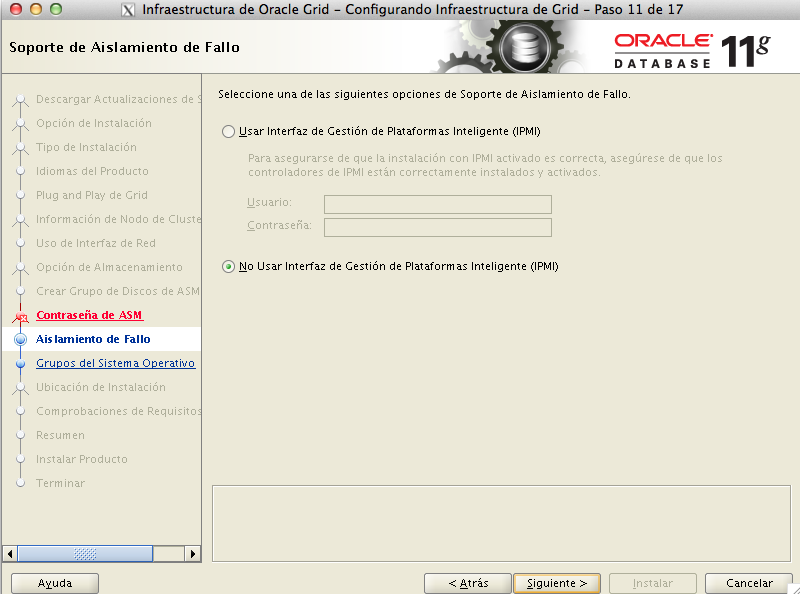

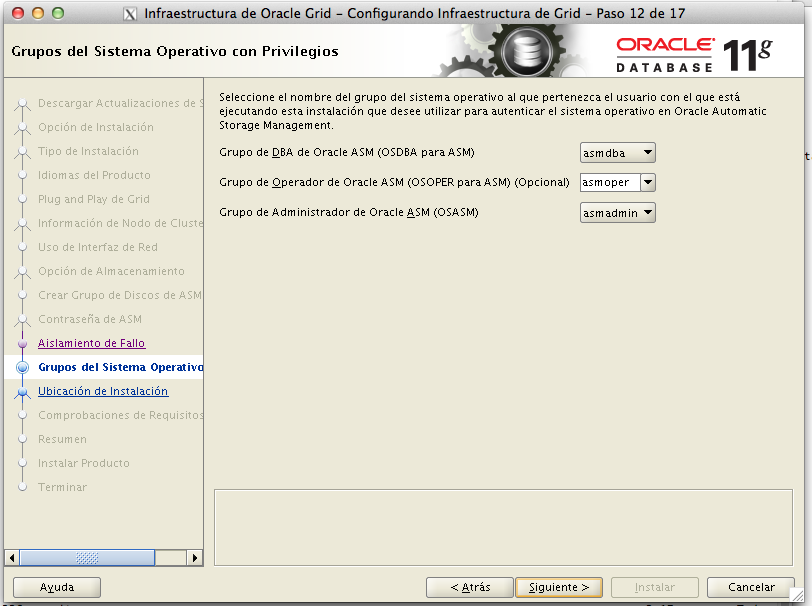

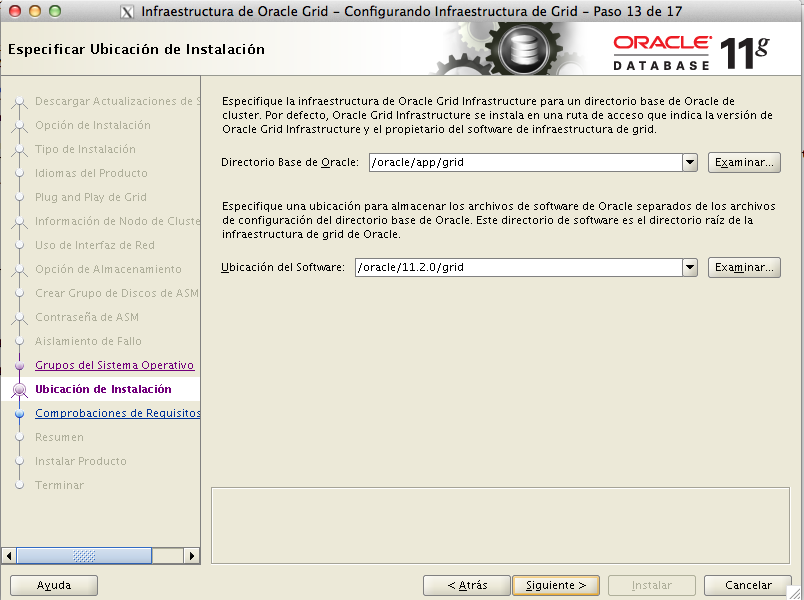

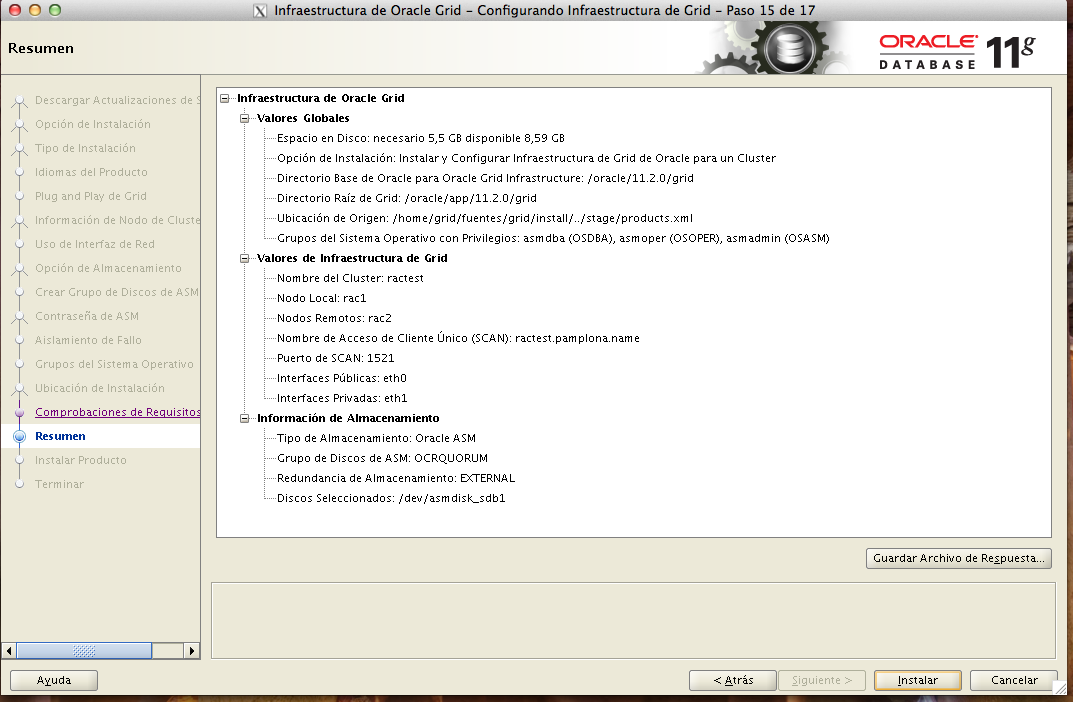

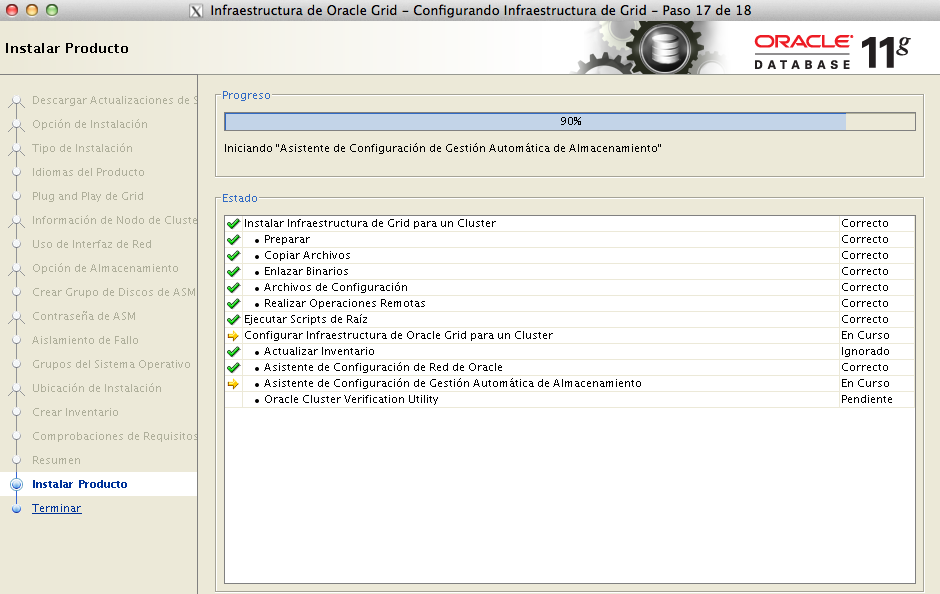

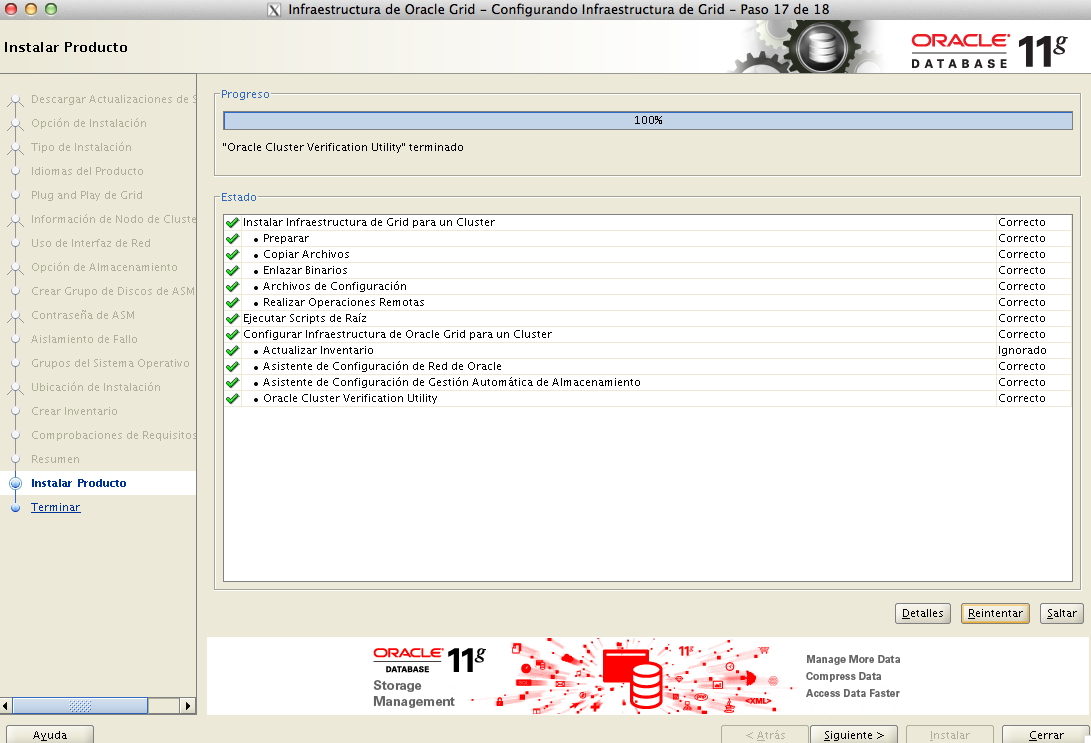

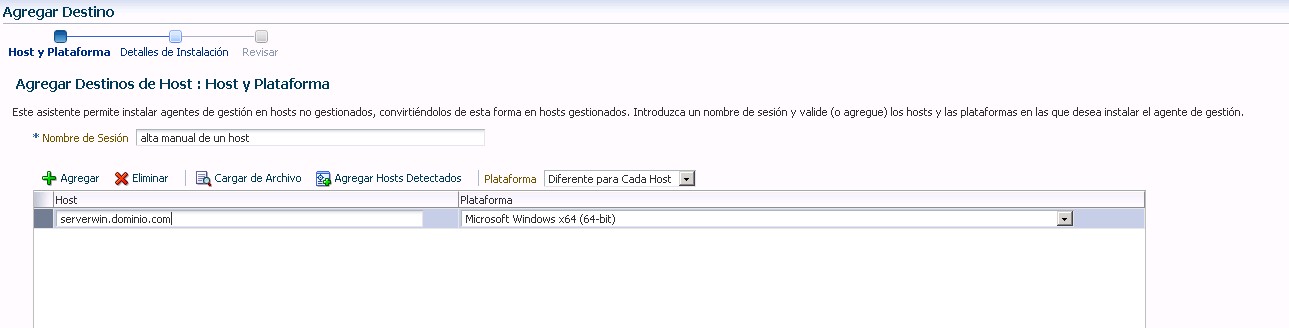

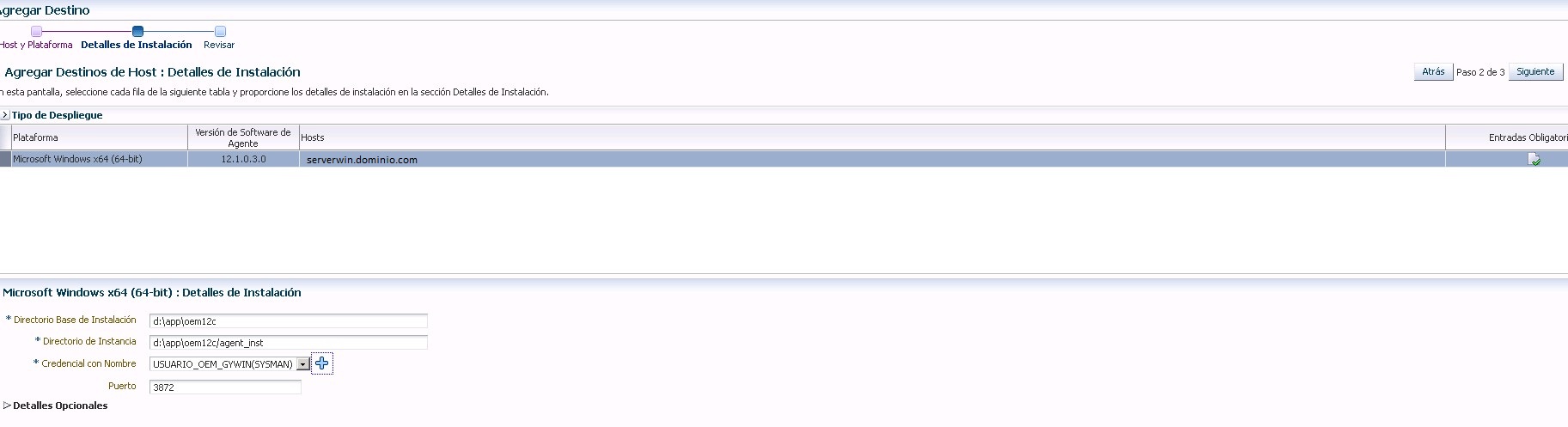

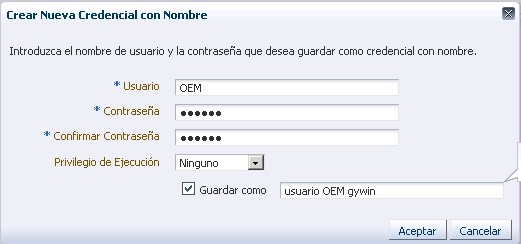

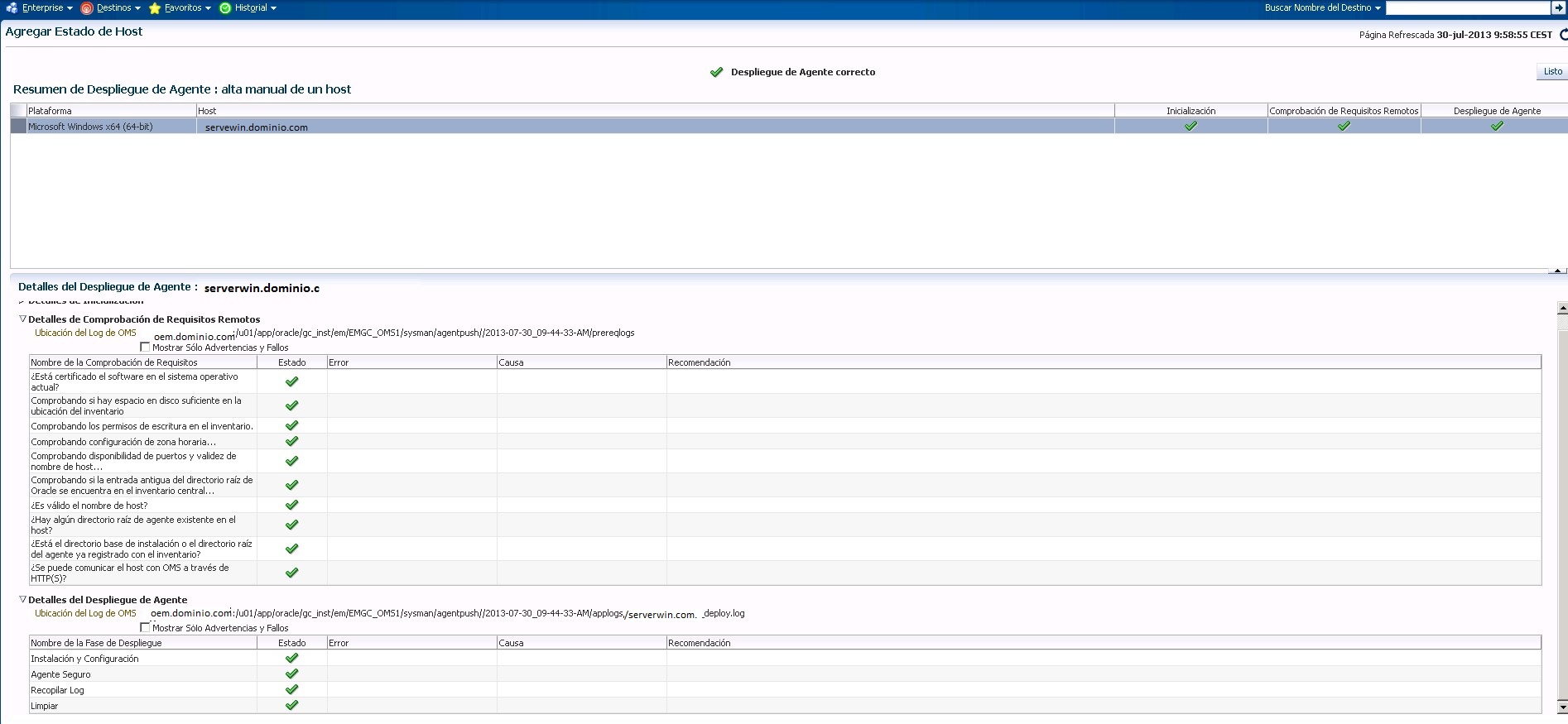

Pero si revisamos los pasos de la instalacion del OEM12c veremos como en ninguna de las ventanas indicamos cual era el usuario de administrador del servidor de aplicaciones que va a correr el OEM12c. Solo indicamos el password.

La respuesta es sencilla :

usuario : weblogic

Contraseña: La de la instalación